Explainable artificial intelligence (XAI) หรือ Explainable AI คือปัญญาประดิษฐ์ที่อธิบายได้ ในบทความนี้ผู้เขียนขอเรียกว่า “AI ที่อธิบายได้” หรือเรียกชื่อย่อว่า XAI เป็นชุดกระบวนการและวิธีการที่ช่วยให้มนุษย์ซึ่งเป็นผู้ใช้งานเข้าใจ ให้ความเชื่อถือ result หรือผลลัพธ์ซึ่งหมายถึงการตัดสินใจที่ทำขึ้นโดยอิงจาก output หรือผลกระทบของ output และมีความเชื่อมั่น output หรือผลผลิตซึ่งหมายถึงข้อมูลที่สร้างขึ้นโดย machine learning algorithm หรืออัลกอริทึมของการเรียนรู้ของเครื่องได้ ถูกนำมาใช้เพื่ออธิบายโมเดล AI ถึงผลกระทบที่เกิดจาก output และอคติที่คาดว่าจะเกิดขึ้น ช่วยกำหนดลักษณะความแม่นยำ ความเป็นธรรม ความโปร่งใส และ outcome หรือผลสัมฤทธิ์ของโมเดลในการตัดสินใจที่ขับเคลื่อนด้วย AI มีความสำคัญต่อองค์กรในการสร้างความไว้วางใจและความเชื่อมั่นเมื่อนำโมเดลไปใช้ในกระบวนการผลิต นอกจากนี้ AI ที่อธิบายได้ยังช่วยให้องค์กรนำแนวทางที่รับผิดชอบมาใช้กับการพัฒนา AI อีกด้วย

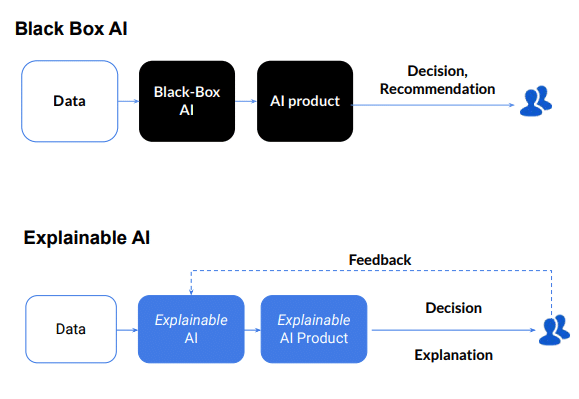

เมื่อ AI มีความก้าวหน้ามากขึ้น มนุษย์ก็ต้องเผชิญกับความท้าทายในการทำความเข้าใจและย้อนกลับไปดูว่าอัลกอริทึมได้ output มาอย่างไร กระบวนการคำนวณภายในขั้นตอนวิธีทั้งหมดกลายเป็นปัญหาที่เรียกว่า “Black Box AI” หรือปัญหากล่องดำของ AI ซึ่งยากต่อการทำความเข้าใจหรือตีความไม่ได้ ถึงจะถูกสร้างขึ้นโดยตรงจากข้อมูลหรือชุดข้อมูล (dataset) แม้แต่วิศวกรข้อมูลหรือนักวิทยาการข้อมูลที่สร้างอัลกอริทึมก็ไม่เข้าใจหรืออธิบายได้ว่าเกิดอะไรขึ้นภายในโมเดลนั้นกันแน่ หรืออัลกอริทึม AI ได้มาซึ่ง output ที่เฉพาะเจาะจงได้อย่างไร

กล่องดำของ AI (Black Box AI) และ AI ที่อธิบายได้ (Explainable AI)

Source: What is Explainable AI (XAI)?

URL: https://www.skedler.com/blog/what-is-explainable-ai-xai/

การทำความเข้าใจว่าระบบที่ใช้ AI นำไปสู่ output ที่เฉพาะเจาะจงได้อย่างไร ความสามารถในการอธิบายช่วยให้นักพัฒนามั่นใจได้ว่าระบบทำงานตามที่คาดหวัง อาจจำเป็นต้องเป็นไปตามมาตรฐานการกำกับดูแล หรืออาจมีความสำคัญในการอนุญาตให้ผู้ที่ได้รับผลกระทบจาก output เช่น ผู้ใช้งานมีส่วนในการร่วมตัดสินใจ ต่อความท้าทายหรือต่อการเปลี่ยนแปลง outcome นั้นๆ

เหตุใด AI ที่อธิบายได้ จึงมีความสำคัญมาก

องค์กรจำเป็นต้องเข้าใจกระบวนการตัดสินใจเกี่ยวกับ AI อย่างถ่องแท้ด้วยการติดตามโมเดลและการรับผิดชอบต่อ AI และไม่ควรเชื่อใจ AI อย่างไม่ลืมหูลืมตา บทความนี้นำเสนอ AI ที่อธิบายได้ ที่จะช่วยให้มนุษย์เข้าใจและอธิบายอัลกอริทึมการเรียนรู้ของเครื่อง (Machine Learning) โครงข่ายประสาทเทียม (Neural Networks) และการเรียนรู้เชิงลึก (Deep Learning) ได้

โมเดลการเรียนรู้ของเครื่องถูกมองว่าเป็นBlack Box AI ซึ่งยากต่อการตีความหรือทำความเข้าใจ เช่น เรามองไม่เห็น process ภายในกล่องดำว่ามีขั้นตอนวิธีในการจัดการตัวแปรหรือพารามิเตอร์ที่ถูก input เข้ามาเป็นจำนวนมาก แต่พอถึงขั้นตอนสุดท้ายกลับได้ output ออกมาจากกล่องดำ ดังนั้น การเรียนรู้เชิงลึกจึงถือว่าเป็นโครงข่ายประสาทเทียมที่มนุษย์เข้าใจได้ยากที่สุด เป็นความเสี่ยงที่เกิดขึ้นมายาวนานในการ train โมเดล AI

นอกจากนี้ ประสิทธิภาพของโมเดล AI อาจคลาดเคลื่อนหรือถดถอยลงได้ เนื่องจากข้อมูลการ test แตกต่างจากข้อมูลการ train ซึ่งทำให้จำเป็นอย่างยิ่งที่ธุรกิจจะต้องตรวจสอบและจัดการโมเดลอย่างต่อเนื่องเพื่อส่งเสริมความสามารถในการอธิบายของ AI ขณะเดียวกันก็วัดผลกระทบต่อธุรกิจจากการใช้อัลกอริทึมดังกล่าว โดย XAI ยังช่วยส่งเสริมความไว้วางใจของผู้ใช้งานระดับ End users ความสามารถในการตรวจสอบโมเดล และการใช้ AI อย่างมีประสิทธิผล นอกจากนี้ยังลดความเสี่ยงด้านการปฏิบัติตามกฎระเบียบ ข้อกฎหมาย การคำนึงถึงความปลอดภัย และชื่อเสียงของ AI ในการผลิตอีกด้วย

XAI ถือเป็นหนึ่งในข้อกำหนดหลักสำหรับการนำ AI ที่มีความรับผิดชอบมาใช้ ซึ่งเป็นระเบียบวิธีสำหรับการนำวิธี AI ไปใช้ในองค์กรจริงในระดับใหญ่โดยต้องมีความบริสุทธิ์ยุติธรรม สามารถอธิบายแบบจำลองได้ และมีความรับผิดชอบต่อสังคม เพื่อช่วยให้นำ AI มาใช้งานได้อย่างมีความรับผิดชอบ องค์กรต่างๆ จำเป็นต้องปลูกฝังหลักจริยธรรมไว้ในแอปพลิเคชันและกระบวนการ AI โดยสร้างระบบ AI บนพื้นฐานของความไว้วางใจและความโปร่งใส

AIที่อธิบายได้ ทำงานอย่างไร

จากบริบทของการเรียนรู้ของเครื่องที่ตีความได้และปัญญาประดิษฐ์ที่อธิบายได้ องค์กรต่างๆ จึงเข้าถึงการตัดสินใจพื้นฐานของเทคโนโลยี AI และมีอำนาจในการปรับเปลี่ยน AI ที่อธิบายได้ ปรับปรุงประสบการณ์ของผู้ใช้ผลิตภัณฑ์หรือบริการได้โดยช่วยให้ผู้ใช้งานหรือผู้บริโภคมั่นใจว่า AI มีการตัดสินใจที่ดีเยี่ยม เมื่อใดระบบ AI ให้ความเชื่อมั่นเพียงพอในการตัดสินใจที่เราไว้วางใจได้ รวมถึงการที่ระบบ AI จะแก้ไขข้อผิดพลาดที่เกิดขึ้นได้อย่างไร

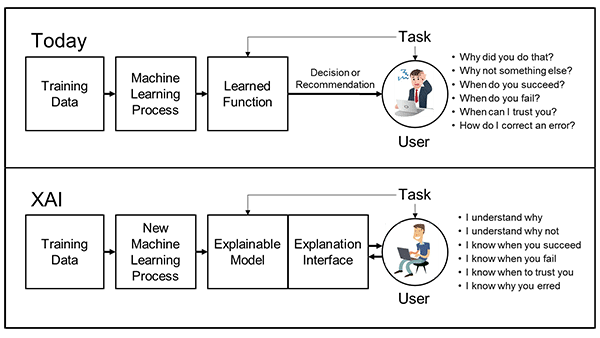

เมื่อวิวัฒนาการของ AI มีความก้าวหน้ามากขึ้น กระบวนการเรียนรู้ของเครื่องยังคงต้องได้รับการทำความเข้าใจและควบคุมเพื่อให้แน่ใจว่า output ของโมเดลถูกต้องแม่นยำ ลองมาดูความแตกต่างระหว่าง AI และ XAI รวมถึงวิธีการและเทคนิคที่ใช้ในการเปลี่ยน AI ให้เป็น XAI และความแตกต่างระหว่างการตีความของ AI และอธิบายกระบวนการ AI ดังนี้

เทคนิค XAI

Source: “Explainable Artificial Intelligence (XAI)”, Dr. Matt Turek, The U.S. Defense Advanced Research Projects Agency (DARPA).

URL: https://www.darpa.mil/program/explainable-artificial-intelligence

เปรียบเทียบ AI และ XAI

ถึงตรงนี้ ผู้อ่านอาจจะสงสัยว่าความแตกต่างระหว่าง AI และ XAI คืออะไรกันแน่

XAI ใช้เทคนิคและวิธีการเฉพาะเพื่อให้แน่ใจว่าสามารถติดตามและอธิบายการตัดสินใจแต่ละครั้งที่เกิดขึ้นในกระบวนการเรียนรู้ของเครื่องได้ ในทางกลับกัน AI มักจะได้จากอัลกอริทึมการเรียนรู้ของเครื่อง แต่นักพัฒนาระบบ AI ไม่เข้าใจอย่างถ่องแท้ว่าอัลกอริทึมได้ output นั้นมาได้อย่างไร ซึ่งทำให้ยากต่อการตรวจสอบความถูกต้องและนำไปสู่การสูญเสียการควบคุม ความรับผิดชอบ และการตรวจสอบ

เทคนิค XAI

การตั้งค่าเทคนิค XAI ประกอบด้วย 3 วิธีหลัก โดยความแม่นยำในการทำนายและการตรวจสอบย้อนกลับจะตอบสนองความต้องการของเทคโนโลยี ในขณะที่ความเข้าใจในการตัดสินใจจะตอบสนองความต้องการของมนุษย์ AI ที่สามารถอธิบายได้ โดยเฉพาะการเรียนรู้ของเครื่องที่อธิบายได้ ดังนี้

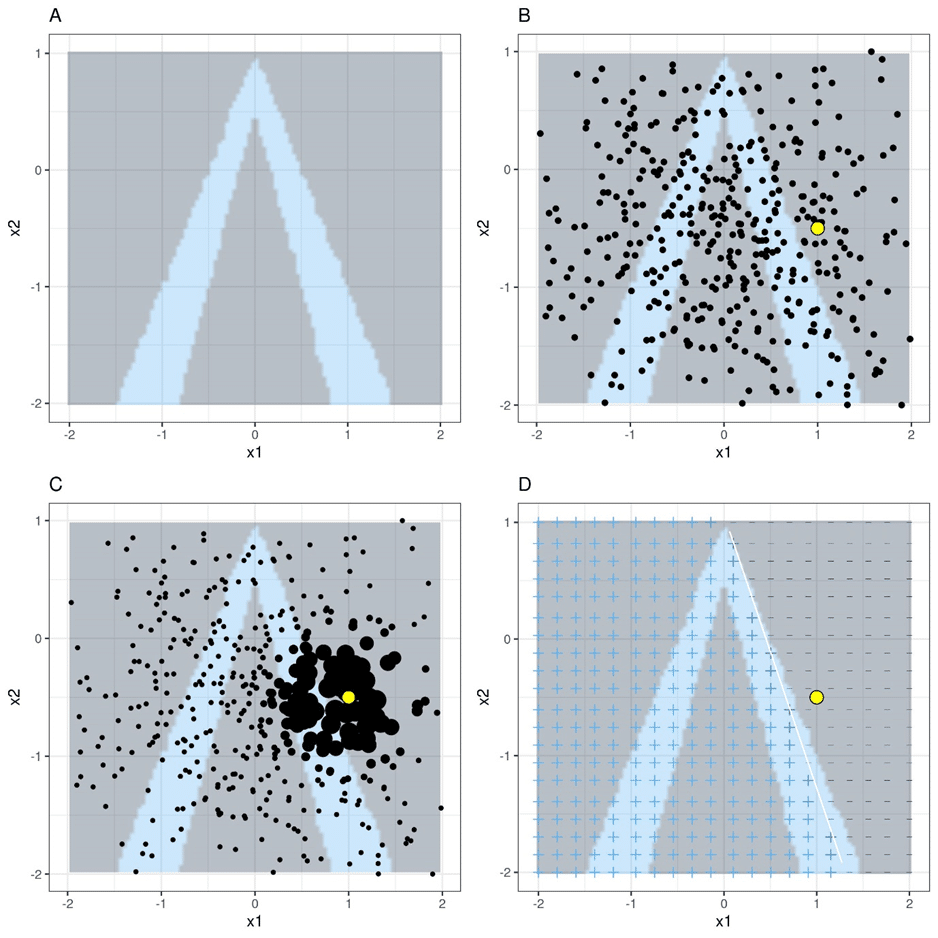

1) ความแม่นยำในการทำนาย (Prediction accuracy)

ความแม่นยำเป็นองค์ประกอบสำคัญที่ส่งผลต่อความสำเร็จของการใช้ AI โดยการทดสอบการจำลองและเปรียบเทียบผลลัพธ์ของ XAI กับผลลัพธ์ในชุดข้อมูลการ train ความแม่นยำในการทำนายสามารถกำหนดได้ โดยเทคนิควิธีการที่นิยมใช้มากที่สุดคือ LIME (Local Interpretable Model-Agnostic Explanations) เป็นแนวคิดของ surrogate model ซึ่งเป็นการใช้ model พื้นฐานอื่นๆ แต่สามารถตีความได้ เช่น linear regression มาช่วยอธิบายผลการทำนายในบริเวณของข้อมูลที่เราสนใจ แทนที่จะไปนั่งหาว่า model ทั้งหมดคิดอย่างไร ซึ่งอธิบายการทำนายของตัวจำแนกประเภทโดยอัลกอริทึมการเรียนรู้ของเครื่อง เป็นเทคนิคที่ให้คำอธิบายผลกระทบของ feature ต่อการทำนายเป็นรายจุดข้อมูล จะถือว่าผู้ใช้งานไม่มีข้อมูลการทำงานภายในของโมเดลที่ต้องการอธิบายเลย โดยจะทำการสร้างโมเดลตัวแทนเรียกว่า Local surrogate ที่เลียนแบบพฤติกรรมของโมเดลตั้งต้นในบริเวณพื้นที่ใกล้เคียงจุดที่ผู้ใช้งานต้องการศึกษาขึ้นมาแทน โมเดลที่ถูกสร้างขึ้นใหม่จะถูกใช้เพื่อสร้างคำอธิบายถึงเหตุผลที่โมเดลตั้งต้นให้คำทำนายต่างๆ ตามที่ปรากฏอย่างไร โดย LIME จะอาศัยการทดสอบสมมุติฐานที่ว่า “จะเกิดอะไรขึ้นกับผลการทำนายของโมเดลที่ทำการศึกษา หากทำการเปลี่ยนแปลงข้อมูลเล็กน้อยที่ input เข้าไปเพื่อใช้ในการทำนาย” ผลจากการทดสอบสมมุติฐานนี้จะนำไปใช้ในการพัฒนาและปรับปรุง Local surrogate ให้เป็นโมเดลตัวแทนให้ดียิ่งขึ้น อัลกอริทึม LIME สำหรับข้อมูลแบบตาราง แสดงดัง ภาพที่ 2 ดังนี้

A) การทำนายแบบ Random forest ที่กำหนดคุณลักษณะ x1 และ x2 คลาสที่ทำนาย: 1 (dark) หรือ 0 (light)

B) จุดใหญ่แสดงตัวแทนที่สนใจ (instance of interest) และจุดเล็กแสดงข้อมูลที่สุ่มตัวอย่างจากการแจกแจงแบบปกติ

C) กำหนดค่าน้ำหนักที่สูงกว่าให้กับจุดที่อยู่ใกล้กับตัวแทนที่สนใจ C) เครื่องหมายของกริดแสดงการจำแนกประเภทของแบบจำลองที่เรียนรู้ใน local จากตัวอย่างที่มีน้ำหนัก เส้นสีขาวแสดงขอบเขตการตัดสินใจ (P(class=1) = 0.5)

อัลกอริทึม LIME สำหรับข้อมูลแบบตาราง

Source: Interpretable Machine Learning, Christoph Molnar

URL: https://christophm.github.io/interpretable-ml-book/lime.html

2) การตรวจสอบย้อนกลับ (Traceability)

การตรวจสอบย้อนกลับเป็นเทคนิคสำคัญอีกประการหนึ่งในการบรรลุผลสำเร็จของ XAI ซึ่งทำได้โดยการจำกัดวิธีการตัดสินใจและกำหนดขอบเขตที่แคบลงสำหรับกฎและคุณลักษณะของ ML ตัวอย่างเทคนิค XAI สำหรับการตรวจสอบย้อนกลับคือ DeepLIFT (Deep Learning Important FeaTures) ซึ่งเปรียบเทียบการทำงานของแต่ละนิวรอนกับนิวรอนอ้างอิง และแสดงความเชื่อมโยงที่ตรวจสอบย้อนกลับได้ระหว่างแต่ละนิวรอนที่ถูกเปิดใช้งาน และยังแสดงความสัมพันธ์ระหว่างนิวรอนทั้งสองด้วย

3) ความเข้าใจในการตัดสินใจ (Decision understanding)

นี่คือปัจจัยด้านมนุษย์ หลายคนไม่ไว้วางใจ AI แต่เพื่อที่จะทำงานกับ AI ได้อย่างมีประสิทธิภาพ พวกเขาจำเป็นต้องเรียนรู้ที่จะไว้วางใจ AI ซึ่งทำได้โดยให้ความรู้แก่ทีมงานที่ทำงานกับ AI เพื่อให้พวกเขาเข้าใจว่า AI ตัดสินใจอย่างไรและเพราะเหตุใด

ความสามารถในการอธิบายเทียบกับความสามารถในการตีความใน AI

ความสามารถในการตีความคือระดับที่ผู้สังเกตการณ์สามารถเข้าใจสาเหตุของการตัดสินใจได้ โดยมนุษย์สามารถคาดการณ์อัตราความสำเร็จสำหรับผลลัพธ์ของเอาต์พุตของ AI ได้ ในขณะที่ความสามารถในการอธิบายจะก้าวไปอีกขั้นและพิจารณาว่า AI ไปถึงผลลัพธ์ได้อย่างไร

Explainable AI) เกี่ยวข้องกับ Responsible AI อย่างไร

Explainable AI หรือ AI ที่อธิบายได้ และ AI ที่รับผิดชอบ มีวัตถุประสงค์ที่คล้ายคลึงกัน แต่มีแนวทางที่แตกต่างกัน ความแตกต่างหลักๆ ระหว่าง AI ที่อธิบายได้ และ AI ที่รับผิดชอบ ดังต่อไปนี้

- AI ที่อธิบายได้ จะพิจารณาผลลัพธ์ของ AI หลังจากทำการคำนวณ results แล้ว

- AI ที่รับผิดชอบ จะพิจารณา AI ในระหว่างขั้นตอนการวางแผนเพื่อให้อัลกอริทึม AI ที่รับผิดชอบก่อนที่จะทำการคำนวณ results

- AI ที่อธิบายได้ และ AI ที่รับผิดชอบ สามารถทำงานร่วมกันเพื่อสร้าง AI ที่ดีขึ้น

ประโยชน์ของ AI ที่อธิบายได้

ใช้งาน AI ด้วยความน่าเชื่อถือและความมั่นใจ

สร้างความน่าเชื่อถือใน AI ที่ใช้ในกระบวนการผลิต นำโมเดล AI ของไปใช้ในการเพิ่มผลผลิตอย่างรวดเร็ว รับรองความสามารถในการตีความและการอธิบายของโมเดล AI ลดความซับซ้อนของกระบวนการประเมินโมเดลในขณะที่เพิ่มความโปร่งใสและการตรวจสอบย้อนกลับของโมเดล

เร่งเวลาเพื่อให้ได้ผลลัพธ์จาก AI

ตรวจสอบและจัดการโมเดลอย่างเป็นระบบเพื่อปรับผลลัพธ์ทางธุรกิจให้เหมาะสมที่สุด ประเมินและปรับปรุงประสิทธิภาพของโมเดลอย่างต่อเนื่อง ปรับแต่งความพยายามในการพัฒนาโมเดลโดยอิงจากการประเมินอย่างต่อเนื่อง

ลดความเสี่ยงและต้นทุนของการกำกับดูแลโมเดล

ทำให้โมเดล AI มีความสามารถในการอธิบายได้และมีความโปร่งใส จัดการตามข้อบังคับ การปฏิบัติตามกฎระเบียบ ความเสี่ยง และข้อกำหนดอื่นๆ ลดค่าใช้จ่ายในการตรวจสอบด้วยตนเองและข้อผิดพลาดที่มีค่าใช้จ่ายสูง ลดความเสี่ยงของอคติที่ไม่ได้ตั้งใจ

แหล่งข้อมูล : https://www.ibm.com/topics/explainable-ai

https://www.skedler.com/blog/what-is-explainable-ai-xai/